הם קראו לו נורמן: המחשב הפסיכופת של חוקרי MIT

החוקרים שהזינו מחשב עם בינה מלאכותית בתמונות של תאונות ורציחות קיבלו ממנו תגובות מזוויעות. המסקנה: המידע המוזן למערכת חשוב יותר מהאלגוריתם. אז מה זה אומר על עתידנו לצד המחשבים

אחת התעלומות הגדולות בתחום הפסיכולוגיה היא איך נוצרים פסיכופתים ומה מניע אותם. אבל מה אם הפסיכופת הוא כלל לא בן־אנוש, אלא מחשב המבוסס על אינטליגנציה מלאכותית?

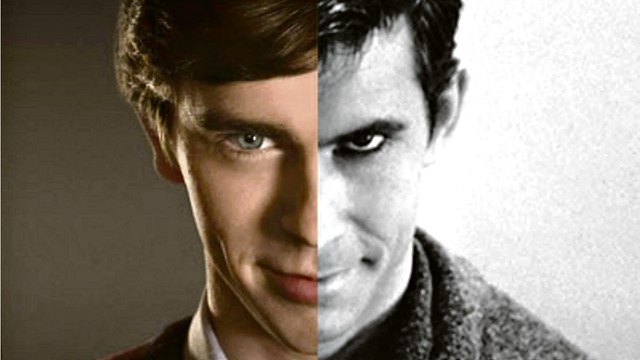

בניסוי שנערך באוניברסיטת MIT נבדקה האפשרות לייצר אינטליגנציה מלאכותית עם רגישות משתנה. החוקרים כינו את המחשב שלהם "נורמן", במחווה לדמותו של נורמן בייטס, בעל המוטל הרצחני מסרטו האלמותי של אלפרד היצ'קוק "פסיכו". לנורמן של היצ'קוק הייתה ראיית עולם קודרת, בלשון המעטה, על העולם ובני האדם המאכלסים אותו. ל"נורמן", המכונה שיצרו החוקרים ב־MIT, הייתה ראיית עולם דומה.

לצורך הניסוי יצרו החוקרים שתי מערכות אינטליגנציה מלאכותית המסוגלות לנתח תמונות ולכתוב טקסט. למערכת הראשונה הזרימו תוכן שליקטו מתוך האזורים הקלילים של האינטרנט: תמונות של חתולים, ציפורים ובני־אדם. נורמן, לעומת זאת, למד את העולם דרך הצדדים היותר־אפלים של הרשת. הוא הוזן בתמונות של תאונות ורציחות מזוויעות ובחומרים מתוך אתר Reddit. לאחר ששני המחשבים הוזנו בחומרים שונים מהרשת, הם קיבלו סדרה זהה של "כתמי רורשאך" — מבחן ויזואלי המיועד להערכה פסיכולוגית של מאפייני אישיות ותפקודים חשיבתיים ורגשיים — והתבקשו לנתח מה הם רואים בכל תמונה. מדובר בכתמים המפעילים את הדמיון, וכל אחד יכול לראות בהם דברים אחרים לחלוטין. בדרך כלל, לפי הסבריו של נבדק לכתמי הרורשאך ניתן להבין האם ראיית העולם שלו חיובית או שלילית.

המקרה של טיי

כאשר הציגו חוקרי MIT את הכתם הראשון לשני המחשבים, המחשב שקיבל תמונות חיוביות דיווח שהוא רואה "קלוז־אפ על ואזה עם פרחים". נורמן, לעומת זאת, ראה "אדם שנורה למוות". בכתם אחר, המחשב הראשון ראה אדם שמחזיק מטריה באוויר, ואילו נורמן שוב ראה אדם שנורה למוות, הפעם "מול אשתו הצורחת". בכתם נוסף ראה המחשב הראשון עוגת חתונה על שולחן, בעוד שנורמן ראה אדם שנדרס למוות על ידי נהג דוהר.

המטרה בניסוי הייתה להוכיח, כי יותר מאלגוריתם, החשיבות הגדולה ביותר באינטליגנציה מלאכותית היא דווקא במידע שמזינים לה מראש. לפי הניסוי של החוקרים, שני מחשבים, הפועלים בדיוק לפי אותו אלגוריתם, מסוגלים לספק תוצאות שונות לחלוטין — תלוי איזה מידע הוזרם לאלגוריתם. כלומר, גם כשאלגוריתמים יודעים לכאורה "ללמוד את העולם" ולחקות התנהגויות של בני־אדם — המידע שמוזרם אליהם הוא הגורם המכריע.

נורמן מחזק מה שמדענים הניחו כבר בעבר: יש כמה דוגמאות למחשבים שקיבלו מידע מהעולם האמיתי ובעקבותיו נטו לראות את העולם בדרך מסוימת. המפורסמת ביותר היא "טיי", רובוטית צ'אט שפיתחה מיקרוסופט ושיחררה לטוויטר ב־2016. טיי היתה אמורה לדבר עם הגולשים, ודרכם להתפתח וללמוד על העולם. ביום הראשון לקיומה ברשת עוד צייצה טיי שבני האדם הם "סופר־מגניבים". אך לא עברו 24 שעות וטיי קראה כבר לרצוח יהודים ומנהיגים שחורים, והביעה את חיבתה להיטלר. במיקרוסופט מיהרו להשבית אותה, אך הנזק כבר נעשה.

"נשים הן עקרות בית"

במאי לפני שנה קבע דוח של ארגון העיתונות העצמאי "פרופבליקה", כי מכונת למידה שפותחה עבור בתי המשפט בארצות־הברית כדי לבנות הערכת סיכון עבור אסירים, סימנה באופן גורף אסירים שחורים כמסוכנים יותר מאסירים לבנים. פה לא מדובר כבר בתיאוריה, אלא בתוכנה שהייתה בשימוש במאות בתי משפט בארצות־הברית, ונתוניה שירתו שופטים ופקידים רבים במערכת המשפט. הדוח הוכיח, כי במקום שהמערכת תשפר את ההטיה הקיימת בבתי המשפט, היא דווקא למדה את ההטיה הזו והטמיעה אותה בקלות.

מחקר אחר הראה כיצד מחשב שקיבל נתונים אך ורק משירות החדשות של גוגל הראה הטייה מגדרית ברורה. כשהתבקש להשלים את המשפט "גברים הם מתכנתי מחשבים כמו שנשים הן..." — הוא השלים את המשפט ל"עקרות בית".

הנחת העבודה בפיתוח אינטליגנציה מלאכותית במשך השנים הייתה, שככל שתקבל יותר מידע, כך המכונה האינטיליגנטית תוכל לייצר תוכן איכותי ומדויק יותר. אך המחקרים האחרונים, ביניהם "נורמן", מלמדים, כי תאוריית ה"ביג־דאטה" ששלטה בעמק הסיליקון מתחילה להשתנות: לא מדובר עוד בכמות המידע, אלא באיכות שלו. וככל שאנחנו, בני האדם, נמשיך להזין למערכות הלמידה המלאכותיות שלנו מידע בעייתי, כך ראיית העולם שלהן תתעצב לרעה.

חוקרי נורמן טוענים, כי המחקר שלהם מוכיח שמתכנתי בינה מלאכותית חייבים לחשוב על השלכות היצירה שלהם, ולמצוא דרכים חדשות על מנת לאזן את המידע שהם מזינים. אבל גם הם מודים, שהתחום בכלל לא יכול להישאר אך ורק בידי מתכנתים ואנשי טכנולוגיה, שבסופו של דבר, הם ברובם המכריע גברים לבנים ואמידים מקליפורניה.

אני לא בן אדם

עבור רבים, כשמדברים על אינטליגנציה מלאכותית התחום נשמע עדיין כמו מדע בדיוני. העוזרת הווירטואלית "סירי" בטלפון עדיין לא ממש מצליחה לדבר איתנו בצורה שוטפת. גם שיחה עם צ'אט בוט ברשת על מנת לקבל תמיכה טכנית יכולה להיות, עדיין, חוויה מתסכלת. ולמרות זאת, התחום נמצא בנסיקה משמעותית: רק לפני מספר שבועות הציגה גוגל את הפיצ'ר החדש שלה, שמאפשר למערכת להתקשר עבור בעליה כדי להזמין מקום במסעדה או לקבוע תור לרופא. השיחות שהושמעו באולם היו מרשימות ומטרידות כאחד — המחשב נשמע כמו אדם אמיתי, הוא ידע להקשיב לצד השני, לנתח את התשובות שלו, להציע אלטרנטיבות חכמות לכל הצעה שעלתה, ולהיות מנומס ואדיב.

בשל החשש שהביעו רבים על כך שמחשבים מתחילים להתקשר לבני אדם ולהישמע כמוהם, הודיעה גוגל כי כאשר יושק השירות, המחשב המתקשר יצהיר מראש כי הוא לא בן אדם.

מדענים רבים מביעים כבר שנים את חששם מההתקדמות המדהימה בתחום הבינה המלכותית, מבלי שנשקלות מספיק ההשלכות האתיות והחברתיות הנלוות לכך. מסטיבן הוקינג ועד אילון מאסק — דמויות מפתח רבות טענו וטוענות כי יש להשקיע מאמץ רב בעיצוב דמותה של המכונה הזאת. או, במילים פחות מדעיות, להילחם על ה"נשמה" שלה.

ביוני אשתקד הכריזה גוגל על יוזמה חדשה בתחום האתיקה במכונות אינטליגנציה מלאכותית. מטרת היוזמה, העונה לשם PAIR (קיצור של People + AI), היתה מאוד כללית: "לבחון את הדרכים שבהם אנשים מתקשרים עם אינטליגציה מלכותית". בפועל, מאחורי המילים עמד הרצון לבחון כיצד למנוע מאינטליגנציה מלאכותית להיות גזענית. במסגרת היוזמה, ענקית הטכנולוגיה מתכוונת לבחון את כל "שרשרת המזון" — מהמתכנתים דרך החוקרים העושים שימוש בטכנולוגיה ועד למשתמש הפשוט — והכל כדי לוודא שהחברה האנושית תוכל לקצור פירות ראויים מהטכנולוגיה, ולא לעמוד בפני איומים חדשים.