דיפ פייק: כל כך פשוט לזייף את המציאות

מפורנו מפוברק עד חשש להטיית בחירות: סרטוני דיפ פייק הם אחד האיומים המדאיגים בעולם, והטכנולוגיה שמאפשרת לייצר אותם לא מפסיקה להתקדם ולהשתכלל. עם שחקנים או בלי, כך עובדים המודלים שמשנים לנו את המציאות. כתבה ראשונה בסדרה

"מערכת הבחירות לנשיאות ארצות-הברית ב-2016 הייתה רק ההקדמה": במילים אלה פנה יו"ר ועדת המודיעין של בית הנבחרים האמריקאי, אדם שיף, לענקיות הטכנולוגיה - פייסבוק, גוגל וטוויטר לפני כשבועיים. מטרת הפנייה - לדחוק במנכ"לי החברות לפרסם מדיניות מוסדרת להתמודדות עם דיפ-פייק בפלטפורמות השונות, כהכנה לבחירות 2020. "ברשתות החברתיות מטילים שקרים משכנעים לתוך שיחות של מיליוני אנשים, לפני שהאמת מספיקה להרים את ראשה. ההשלכות על הדמוקרטיה עלולות להיות הרסניות", כתב שיף.

החשש בארצות-הברית מפני מערכת בחירות ספוגה בזיופים וכזבים, הוא לא חשש מופרך. שלוש שנים חלפו מאז בחירות 2016 - בהן פייק ניוז בשילוב פרסום ממוקד (מיקרו-טרגטינג) ומפולח לפי מאפיינים פסיכולוגיים ואלמנטים של שכנוע, הובילו למשבר אמון עמוק, גם במערכת הפוליטית אבל גם בטכנולוגיה שמאפשרת את זה. פרשת קיימברידג' אנליטיקה היא הדוגמה הבולטת, אבל גם בוטים, חוות טרולים, ושפע של כותרות מפוברקות - כולם לקחו חלק משמעותי בהליך הדמוקרטי. בשלוש השנים האלה, חלה קפיצת מדרגה משמעותית בטכנולוגיה שלוקחת את הזיוף כמה צעדים קדימה: דיפ-פייק. מה זה בדיוק ואיך זה עובד?

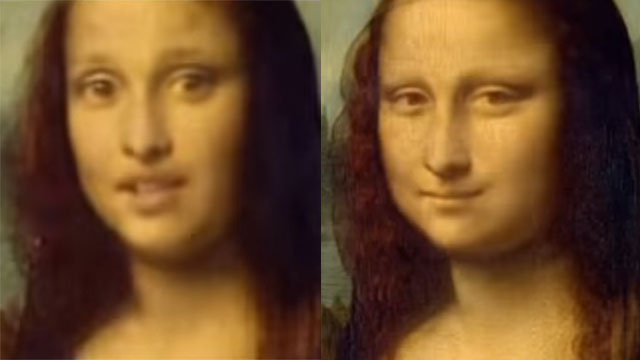

דיפ-פייק (DeepFake), או "זיוף עמוק", מתייחס לעובדה שהזיוף נעשה באמצעים טכנולוגיים מתוחכמים הרבה יותר - המבוססים על "למידה עמוקה" (Deep Learning) - ענף המשוייך לתחום של בינה מלאכותית (AI). התופעה קרמה עור וגידים ב-2017, והיא החלה מהוכחת יכולת איזוטרית למדי של משתמש באתר רדיט, שיצר סרטונים פורנוגרפיים שבהם הושתלו פרצופים של כוכבות הוליוודיות. משם, הקפיצה לזיוף כולל של סרטוני וידיאו המציגים מפורסמים, פוליטיקאים ואפילו מארק צוקרברג אחד - הייתה מהירה למדי.

יש כל מיני דרכים לייצר סרטוני דיפ-פייק, אבל כולן נשענות על אותם עקרונות בסיסיים: מודלים של למידת מכונה מייצרים תוכן מזויף על בסיס מאגרי מידע גדולים. ככל שהמאגר גדול ומכיל יותר פרטים, כך התוצאה תהיה ריאליסטית יותר. בנוסף, יש צורך בכוח מחשוב משמעותי, אבל אפליקציות פשוטות כבר צצות ומאפשרות זיופים ברמה נמוכה יותר, בלחיצת כפתור. בהרבה מקרים, סרטוני זיוף עמוק מיוצרים באמצעות רשתות המכונות Generative Adversarial Network, או בקיצור GAN. הרשת בנויה בעיקרון משתי מערכות AI שמתחרות ביניהן - הגנרטיבית מייצרת זיוף, ואז מבקשת מהדיסקרימנטיבית "להעריך" אם מדובר בסרטון אמיתי או מזוייף. בכל פעם שהתוצר מזוהה כזיוף, זה מאותת למערכת הגנרטיבית מה לא כדאי לעשות בניסיון הבא.

כאמור, כדי להדביק פנים של אדם אחד על אדם אחר - נדרשות שתי מערכות נתונים. המכונה ניזונה מהן, ומתאמנת על בסיסן. רצוי שהמערכות יהיו קרובות אחת לשנייה ככל האפשר - בזוויות הצילום, בתאורה ובהבעות הפנים. אפשר להשתמש בשני סטים קיימים של נתונים, וזו אחת הסיבות לכך שסרטונים של טראמפ כל-כך פופולריים בקרב נסייני הדיפ-פייק, יש הרבה מאוד קטעי וידיאו ואודיו שלו זמינים לשימוש. אם רוצים להעמיק את הזיוף אפילו יותר - אפשר להשתמש במערכת נתונים שנוצרה במיוחד עבור הסרטון, ולצלם שחקנים וחקיינים. באופן הזה, אפשר להימנע משימוש בקול מסונתז אבל גם ליצור אשליה קרובה יותר למציאות בעזרת שחקנים שמחקים את תנועות הגוף והמניירות של המודל אותו רוצים לזייף.

קפיצה טכנולוגית

בתוך פחות משנתיים - הזמן שחלף מאז סרטוני הפורנו המזוייפים שהועלו לרדיט ויצרו שיח סביב התופעה, חלה קפיצה משמעותית ביכולת הטכנולוגית. רשתות GAN משמשות היום לא רק במסגרת של סרטוני וידיאו: הן לומדות לייצר פרצופים של אנשים שלא קיימים; מייצרות תמונות אילוסטרציה שלא צולמו מעולם; קטלוגים שלמים של אופנה שמעולם לא עוצבה על גופם של דוגמנים שאינם קיימים; ואפילו יצירות אמנות מזוייפות, שיוצרו באמצעות אלגוריתם ונמכרו בעשרות אלפי דולרים, או כאלה שהתעוררו לחיים וייצרו סרטוני וידיאו על סמך מאגר תמונות בלבד.

בינתיים, גם סרטוני הווידיאו הופכים יותר ויותר משכנעים. אם בהתחלה סרטונים מזוייפים חייבו הקלטת קול - בדרך כלל על-ידי חקיינים רלוונטיים, היום אפשר לייצר גם קטעי קול מזוייפים על סמך מודלים של למידה עמוקה ומאגרי מידע קוליים רחבים. רשתות GAN מייצרות גם מוזיקה חדשה שאף אחד לא הלחין, וברדיט יש פורום ייעודי שבו מכונות שאומנו על מאגרי מידע בנושאים מסויימים מתווכחות עם עצמן. ההתקדמות האחרונה כוללת סרטוני דיפ-פייק שאפשר לייצר בהם מניפולציות באמצעות הקלדה מחדש של תמליל הסרטון, זה עד כדי כך פשוט - וזה הופך יותר ויותר נגיש.

לפני כחודשיים, הופץ בארצות-הברית סרטון וידיאו שבו הופיעה ננסי פלוסי, חברת המפלגה הדמוקרטית. הסרטון חרך את פייסבוק וטוויטר, מאחר ופלוסי מוצגת בו כאילו היא שיכורה לחלוטין, או לכל הפחות סובלת מבעיות נפשיות קשיות. למעלה משני מיליון צפיות ועשרות אלפי תגובות גרף הסרטון הזה ברשתות החברתיות, והוא הפך לאחת הדוגמאות הבולטות לסיכול ממוקד של פוליטיקאית באמצעות הטכנולוגיה. אלא שדי מהר התברר שבכלל לא מדובר בסרטון דיפ-פייק. למעשה, המניפולציה שנעשתה בו היא דבילית למדי: הסרטון נערך כך שהוא הואט בכ-25 אחוזים, מה שגרם לפלוסי להיראות ולהישמע כאילו היא מושכת מילים.

הסרטון הזה קיבל תהודה משמעותית, בין היתר מפני שהוא שותף על-ידי עורך-הדין הפרטי של טראמפ. פלוסי פנתה לפייסבוק בדרישה להסיר אותו מהפלטפורמה - אבל זו התנערה והעדיפה להטיל את המשימה על "בודקי העובדות" - גופים שאיתם פייסבוק נמצאת בהסכמים, שאמורים לאמת תכנים המופצים ברשת החברתית, ולסמן תוכן מזוייף. הפאניקה המסתמנת בארצות-הברית סביב הנושא של זיופים עמוקים היא לא חסרת בסיס, אבל הדוגמה של פלוסי מוכיחה שזיופים ומניפולציות תמיד היו, ושלפעמים אפילו המטופשים והלא מתוחכמים שבהם - מצליחים להפיל בפח מיליוני אנשים.