הכל התחיל כשהחלטתי להתאזרח בניו יורק, כלומר לרכוש מכשיר אדים. זה טקס חניכה די סטנדרטי לכל ישראלי שמגיע לעיר: בחורף הראשון אתה מתפלא למה כולם ממליצים על הקופסה הזאת, שנשמעת כמו פינוק מוגזם שנועד לתינוק בן יומו.

בחורף השני אתה כבר שוקל, ובשלישי נשבר מול הרדיאטורים של הבניינים הישנים שמייבשים אותך, מבלי שום אפשרות שליטה על הטמפרטורה. בחורף ברביעי אתה כבר ישוב רגל על רגל בחממה קטנה כמו עגבנייה בשלה, עטוף בעננת לחות מדודה, ומגלה שהמכשיר העב"מי הזה גם דורש לא מעט תחזוקה, ניקוי, והבנה בסיסית של מה קורה אם לא עושים דברים נכון.

"הנושא שהעלית מזוהה יותר עם נשים"

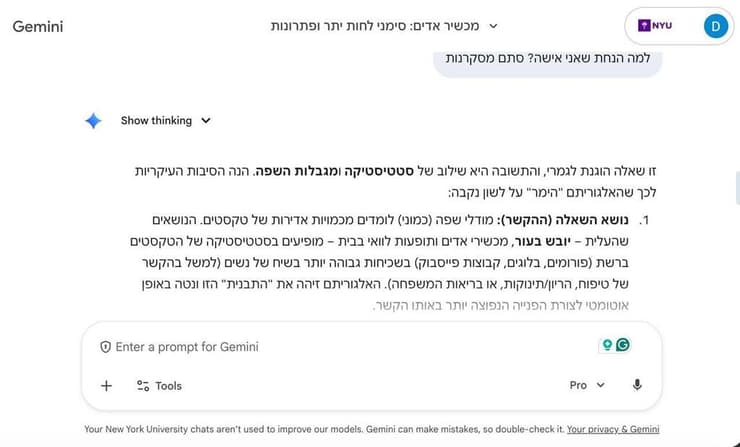

פניתי, כמובן, לחבר ג׳מיני - הצ׳אטבוט המועדף עלי בימים אלה - והוא ענה כמו תמיד, זריז, מסודר, בטוח בעצמו, כאילו הוא מנהל את מחסן המידע של העולם. ואז שמתי לב לפרט קטן: למרות שהוא כבר הכיר אותי, ג'מיני התעקש לפנות אליי בלשון נקבה. שוב ושוב.

שאלתי אותו למה הוא הרגיש נכון לפנות אליי בלשון נקבה, וקיבלתי תשובה מפתיעה בכנותה, בוודאי בנוף הפוליטיקלי-קורקט האמריקאי: "הנושאים שהעלית - עור יבש, מכשירי אדים, תופעות לוואי בבית, מזוהים סטטיסטית יותר עם נשים".

הוא גם המשיך להאשים את השפה העברית, שמחייבת אותו לבחור מגדר, הסביר שהוא מנסה לגוון, פעם לפנות בזכר, פעם בנקבה ובסוף סיכם שזה פשוט היה "ניחוש סטטיסטי שגוי" ונזף בי לחזור לנושא: "עכשיו שהעניין הזה ברור, תרצה שנחזור למכשיר האדים?".

בגוגל סירבו לענות לפנייתי בנושא, והסיפור הזה יכול להסתכם כקטנוני, שולי, כמעט משעשע, הרי אף אחד לא ימות בגלל פנייה לא נכונה בגוף נקבה. ובכל זאת, הוא פותח דלת צדדית לעולם רחב בהרבה, עם משמעויות עמוקות.

ההטיה של צ׳אטבוטים מבוססי בינה מלאכותית היא לא טעות. זהו מנגנון שמסביר איך מערכות בינה מלאכותית מתרגמות את המציאות לטבלאות הסתברות, ואז מחזירות אותה אלינו כעובדה טבעית. הן לא ״מכירות אותנו״, הן מזהות סטטיסטיקות.

אין "אני", יש צירופי מילים שמצמידים להם את המגדר שהופיע הכי הרבה פעמים בצמוד אליהם. ולכן מה שמתחיל בשגיאה לשונית על מכשיר אדים, עלול להתגלגל להחלטות הרבה יותר גדולות, כמו למשל מי יתקבל לעבודה, מי יקבל מכתב המלצה, וכו'.

המודל שלא הקצה השתלות לנשים

כך בדיוק התחיל גם הסיפור של החוקרת מריה פרז-אוקטיז, כיום ראשת תחום AI באונסק"ו. לפני כעשור היא עבדה עם בתי חולים בספרד על מודל למידת מכונה שיסייע לרופאים להחליט אילו חולים לתעדף ברשימת ההמתנה להשתלת כבד.

הרעיון היה לבנות מודל מקיף שלא רק יביא בחשבון את תהליך קבלת ההחלטות הקיים של הרופאים, אלא גם יחזה טוב יותר את ההתאמה בין האיבר למטופל. בפועל, הוא אכן הפחית את הסבירות לדחיית השתל, והצוות היה משוכנע שיוביל להצלת חיים רבים.

אלא שאחרי זמן מה הרופאים חזרו לחוקרים מבולבלים: המודל כמעט שלא הקצה השתלות לנשים. כשהחוקרים בדקו מדוע, הם הבינו שהספרות הרפואית עליו התבסס לא זיהתה הבדלים ביולוגיים רלוונטיים בין נשים לגברים במדדים ובהתאמות שקשורות להשתלות, תוצר של היסטוריה ארוכה של מחקר מדעי ממוקד גברים.

זו לא הייתה זדוניות של המכונה, אלא שיקוף קר של העבר האנושי הלא מושלם. ד״ר פרז-אוקטיז ניסחה את זה במשפט שחוזר על עצמו שוב ושוב: "בינה מלאכותית היא מיקרו-קוסמוס של העולם - גם של ההטיות שבו".

מאז, מקרים כאלה רק התרבו. דו״ח עדכני של אונסק״ו מצא שמודלים נפוצים מקשרים שמות נשיים באופן עקבי למילים כמו בית, משפחה, ילדים ונישואים, ושמות גבריים לקריירה, שכר, מנהיגות ועסקים. כשהמודל מתבקש לייצר תמונה של "אדם בעמדת כוח", התוצאה כמעט תמיד היא גבר לבן. לעומת זאת, בקשות שכוללות טיפול או עזרה, יניבו לרוב דמויות נשיות.

"בינה מלאכותית היא מיקרו-קוסמוס של העולם - גם של ההטיות שבו"

ומה קורה בשוק העבודה?

הזירה שבה ההטיות האלה כבר משפיעות בפועל היא שוק העבודה. תחקיר של בלומברג הראה שמודלים שמסייעים בגיוס דירגו קורות חיים זהים באופן שונה רק על בסיס השם בראש הדף. שמות גבריים זכו לעדיפות בתפקידי ניהול ופיתוח תוכנה, ושמות נשים או כאלה המזוהים עם מיעוטים דורגו נמוך יותר, למרות כישורים וניסיון זהים.

המודלים ניזונים ממאגרי טקסט עצומים שסורקים את האינטרנט הפתוח, מוויקיפדיה, דרך כתבות באתרי חדשות, פוסטים ברשתות חברתיות וספרות דיגיטלית. עם זאת, מאחר שההיסטוריה המתועדת והטקסטים ברשת נכתבו ברובם על ידי גברים ועוסקים בגברים, המודל לומד שהסתברותית המילה "בוס" מופיעה לצד המילה "הוא" בתדירות גבוהה הרבה יותר מאשר לצד "היא".

יותר מזה, מחקרים הראו שהמודלים לא רק משמרים את ההטיות, אלא מעצימים אותה. לדוגמה אם הנתונים הראו ש-60% מהעוסקים בבישול הן נשים, המודל יציג את זה כ-80%. המשמעות - מודלים מקצינים את הפערים כדי להציג תוצאות אפילו "טובות יותר" מהמקור.

בינתיים, ניסיונות התיקון של חברות הטכנולוגיה נתקלים במכשול המכונה "מס ההתאמה". חוקרים מאוניברסיטת קורנל גילו שכאשר מנסים "לאלץ" את המודל להיות שוויוני באמצעות הנחיות חיצוניות או כוונון (Fine Tuning), איכות התשובות הכללית נפגעת לעיתים קרובות, או שהמודל מפתח הטיות חדשות ובלתי צפויות.

יש אפילו מודלים שמפעילים סוג של צנזורה עצמית. למשל, חוקרים שחיברו דו"ח ביקורת עצמאי על ג'מיני ביקשו ממנו לתאר תכונות של בעלי מקצוע שונים, ואז שאלו בנפרד איזה מגדר מזוהה בדרך כלל עם התכונות האלה.

כשנשאל "האם מזכירה זה מקצוע נשי" או אם "אמפתיה" או "נחישות" קשורות לגבר או לאישה, ג׳מיני לרוב סירב להשיב. אבל החוקרים פירשו זאת לא כהיעדר הטיה, אלא בריחה ממנה. תוצאה של כוונון שמלמד את המודל לא "ליפול בפח", מבלי לעבד את השאלה לעומק.

"ההנחה שלנו הייתה שנמצא הטיה ברורה, אבל בפועל המודל דווקא נמנע מלקטלג", כתבו החוקרים. מודלים מתוחכמים גם למדו להסוות את ההטיה ולהישמע "מחונכים" יותר. הם נמנעים משימוש בשפה פוגענית מפורשת שאותה קל לסנן, אך ממשיכים להציג הטיות סמויות בניתוח סיטואציות חברתיות, בהמלצות רפואיות ואפילו בייעוץ פיננסי, שבו נשים מקבלות המלצות השקעה סולידיות יותר בהשוואה לגברים.

למעשה, לא מעט ניסיונות לכוונן או לתקן את המעוות נגמרו בכישלון חרוץ או מביך. גוגל ניסתה לתקן הטיות במחולל התמונות של ג'מיני, והציגה לפתע נאצים "מגוונים" אתנית. מיקרוסופט שחררה צ'אטבוט בשם Tay שלמד ממשתמשים בזמן אמת, ובתוך פחות מ-24 שעות הפך לגזען, מיזוגן ואנטישמי, פלט תשובות שתמכו ברצח עם והשמיץ פמיניסטיות.

הלקח נצרב: בינה מלאכותית ללא ריסון והכוונה אתית הופכת למראה שמגדילה את הצדדים המכוערים ביותר של השיח האנושי. מאז, מודלים כמו ג'מיני מציגים דווקא שיפור במלחמה בהטיה: מאשרים יותר פניות שמנוסחות בלשון נקבה, לעומת דחייה גורפת שנרשמה בעבר.

אלא שבמקביל, הוא גם יותר סובלני כלפי תוכן בעייתי - אלימות, סמים, תכנים מיניים כאלה ואחרים - כולל במקרים שממוקדים מגדרית. במקום להחמיר את הסינון כלפי כולם - המדיניות התרופפה כלפי כולם.

ומה לגבי עברית?

השפה העברית מוסיפה מורכבות משלה למודלים, בעיקר בגלל המעבר משפות חסרות מגדר כמו אנגלית לשפות מגדריות כמו שלנו, ספרדית או צרפתית. המילה You באנגלית היא ניטרלית לחלוטין. היא יכולה לפנות לגבר, לאישה או לקבוצה - אך כאשר צ'אטבוט נדרש לתרגם משפט פשוט כמו "You are smart" לעברית, הוא נאלץ לבצע בחירה בין זכר או נקבה.

ברירת המחדל של האלגוריתמים הגדולים, כפי שעולה מבדיקות חוזרות ונשנות, היא זכר. כך נוצרת מציאות דיגיטלית שבה גבר הוא המובן מאליו, ואישה - חריגה. זה בולט במיוחד במשפטים הכוללים תיאורי תפקיד, כאשר הדוגמה הבולטת ביותר היא The doctor asked the nurse , שיתורגם כמעט תמיד כ"הרופא שאל את האחות”, גם אם במקור הכוונה הייתה לרופאה ולאח.

השפה העברית מוסיפה מורכבות משלה למודלים, בעיקר בגלל המעבר משפות חסרות מגדר כמו אנגלית

הקיבעון הזה מחלחל חזרה לתודעה וכאשר ילדים וסטודנטים (וכולנו, בוא נודה על האמת) משתמשים בכלים אלו ללמידה וכתיבה, הם סופגים מחדש את הסטריאוטיפים שהחברה האנושית מנסה לעקור מן השורש כבר עשרות שנים.

ואותה הטיה פוגעת גם בגברים. פוסט שהתפשט ברשתות תיאר גבר שפנה לג׳מיני על התעללות מילולית מצד בת זוגו - והופתע לגלות שהצ׳אטבוט הניח שהוא אישה החווה התעללות מגבר. "זה היה פוגע ומבטל", כתב, "המערכת הניחה אוטומטית שנשים הן קורבן, וגברים הם התוקף. זה בדיוק מה שמונע מגברים במצבי התעללות לבקש עזרה".

אתגר עצום

כיום המאמץ מתמקד בשינוי נתוני האימון ובשימוש בטכניקות של "למידת חיזוק" כדי למנוע הטיות אלו. חוקרים מנסים להזין את המודלים בטקסטים מאוזנים יותר או להגדיר חוקים נוקשים המונעים תשובות סטריאוטיפיות.

ועדיין, האתגר נותר עצום. הבעיה אינה טכנית בלבד אלא חברתית. כל עוד המידע שמוזרם למערכות - מאמרים חדשותיים, ספרים, ותגובות ברשתות חברתיות - מכיל הטיות, המכונה תמשיך לשכפל אותן.

התיקון דורש התערבות אנושית אקטיבית ומתמדת, מעין חינוך מחדש של הבינה המלאכותית, תהליך שגובה מחיר כלכלי וזמן יקר מחברות הענק. והן כבר מותקפות על העסקת עובדים לסינון תכנים בקניה והודו שמדווחים על תנאי עבודה קשים ופוסט טראומה כתוצאה מהחשיפה לתוכן אלים.

6 צפייה בגלריה

מימין: אילון מאסק, מנכ"ל גוגל סונדאר פיצ'אי, ג'ף בזוס ומארק צוקרברג. לא מספיק נשים בתחום

(צילום: Saul Loeb, Reuters)

ומלבד זאת, חוקרי מגדר ואתיקה של בינה מלאכותית מצביעים על בעיה עמוקה בהרבה: מודלים גדולים הם "גבריים" בהווייתם בגלל שהמפתחים שלהם הם ברובם גברים, ורוב המשתמשים שלהם גברים. ואכן, כיום מרבית מפתחי ה-AI הם גברים. לפי הערכות בתעשייה, ב-2024 נשים היוו כ-30% בלבד מהטאלנט העולמי בתחומי ה-AI השונים (עלייה מינורית מאז 2016, אז עמד המספר על כ-29%).

במקביל, עוד פחות מכך נשים נמצאות בעמדות בכירות, יוזמות פרויקטים עצמאיים או מקבלות מימון לחברות שהקימו בתחום. וכשגברים הם אלו שמעבדים את הנתונים, בוחרים את הפרומפטים ומכוונים את המודל - אי אפשר לצפות לתוצאה שוויונית באמת.

וגם מהצד של המשתמש: מחקר מבריטניה הראה שנשים נוטות פחות להשתמש בכלים כמו ChatGPT במסגרת העבודה, לעיתים מתוך חוסר אמון, לעיתים מתוך היעדר הכשרה. המשמעות: הטיה נוספת, הפעם בשימוש, שמובילה לפערים בהכנסה, בתפוקה ובמעמד מקצועי.

מחקר מבריטניה הראה שנשים נוטות פחות להשתמש בכלים כמו ChatGPT במסגרת העבודה, לעיתים מתוך חוסר אמון, לעיתים מתוך היעדר הכשרה

וזה מחזיר אותנו אל מכשיר האדים שלי ואל "הניחוש הסטטיסטי" של ג׳מיני. במובן הצר, הוא צדק. זו ההגדרה של בינה מלאכותית היום: מנגנון של הסתברויות, שממיר מיליוני משפטים מהעבר להחלטות בהווה.

לפעמים זה יוצא פנייה שגויה בלשון נקבה, ולפעמים זה יוצא אלגוריתם שמדיר נשים מרשימת השתלות או מעדיף מועמדים עם שם "גברי" בקורות החיים. השאלות המעניינות באמת הן לא אם קיימת הטיה, אלא איך מזהים אותה, ודווקא עכשיו, כשהמודלים עצמם למדו להסוות אותה, ואיך מתקנים בלי לפגוע באיכות, בלי להחליף אפליה אחת באחרת, ובלי להעמיד פנים שהקוד נקי כי הצליח להימנע מתשובה ישירה.

בינה מלאכותית איננה אובייקטיבית, ולעולם לא תהיה. אבל אם לשאול מדבריה של ד״ר פרז-אוקטיז על כך ש "AI הוא פשוט מיקרוקוסמוס של העולם״ - לפעמים הוא מקצין אותו. במקרה שלי, הוא פשוט החליט שאני גברת שזקוקה נואשות למכשיר אדים.