השתמשתם פעם ב-ChatGPT במסגרת העבודה? אתם לא לבד. לפי ההערכות, יותר מ-200 מיליון בני אדם משתמשים בצ'אטבוט הפופולרי לפחות פעם בחודש, ועבור חלק ניכר מהם מדובר בראש ובראשונה בכלי עזר שמסייע להם להתמודד עם המטלות השונות בעבודה – ניסוח מיילים, יצירת חומרים שיווקיים ואפילו כתיבת קוד.

3 צפייה בגלריה

העובדים התאהבו ב-ChatGPT. עבור המעסיקים מדובר בסיוט

(צילום: rafapress / Shutterstock.com)

עוד כתבות שיעניינו אתכם:

אתר Fishbowl, שמסייע ביצירת קשרים עסקיים, ערך בינואר האחרון סקר בקרב 12 אלף עובדים, וגילה כי 43% מהם השתמשו ב-ChatGPT או בכלי בינה מלאכותית אחרים במסגרת העבודה שלהם. אבל מה שנשמע בהתחלה כמו Win־Win מבחינת המעסיקים, שנהנים על פניו משיפור בתפוקה ובאיכות התוצרים של העובדים, הולך ומתגלה ככל שחולף הזמן כחרב פיפיות. יותר ויותר חברות מביעות בחודשים האחרונים הסתייגות משימוש בצ'אטבוטים כמו ChatGPT של OpenAI, בארד של גוגל, בינג של מיקרוסופט וכלים נוספים. חלקן אפילו מונעות את הגישה לכלים האלה באמצעות הרשת הארגונית.

הסיבה לכך קשורה לדרך שבה הכלים עובדים: ברוב הצ'אטבוטים, ברירת המחדל היא שהשיחות של המשתמשים נשמרות על השרתים של המפתחות, והן שומרות לעצמן את האפשרות לבחון אותן בעין אנושית על מנת לשפר את התשובות של הצ'אטבוטים בעתיד. לא רק זאת: כל מידע שמוזן למודלים האלה עשוי לשמש לאימון שלהם בעתיד.

החשש, אם כך, הוא שעובד יזין לתוך הצ'אטבוט מידע עסקי סודי, או חלק מקוד של תוכנה מסוימת, והמידע הרגיש הזה יגיע לעיניהם של עובדים ב-OpenAI, גוגל או מיקרוסופט. אפשרות לא פחות גרועה היא שהצ'אטבוט עצמו "ידליף" את המידע בשיחה עם משתמשים אחרים. בחלק מהצ'אטבוטים אמנם ישנה אפשרות לשנות את ההגדרות באופן ידני כך שהשיחות לא יישמרו או ישמשו לאימון שלהם, אך ספק אם רוב המשתמשים מודעים בכלל לאפשרות הזאת.

מידע דולף

אפל הייתה אחת החברות הראשונות שזיהו את הבעיה, ולפי דיווחים היא הגבילה כבר לפני חודשים את הגישה של עובדיה ל-ChatGPT. בחודש שעבר חשף "וול סטריט ג'ורנל", כי במזכר שנשלח לעובדי אפל הוסבר שבחברה חוששים מדליפה של מידע רגיש. אפל אסרה על העובדים גם להשתמש ב-GitHub CoPilot, כלי להשלמה אוטומטית של שורות קוד, שפותח גם הוא על ידי OpenAI. החשש מובן לחלוטין לאור שיתוף הפעולה הצמוד של OpenAI עם מיקרוסופט, אחת היריבות הגדולות של אפל.

גם סמסונג אסרה על עובדיה להשתמש ב-ChatGPT ובכלים דומים במכשירי החברה וברשת הפנימית שלה, לאחר שגילתה כי עובדים חשפו קוד רגיש בפני הצ'אטבוט של OpenAI. בנוסף, ביקשה החברה מעובדים שמשתמשים בצ'אטבוטים במכשירים פרטיים להיזהר שלא לחשוף מידע שעלול לסכן את הקניין הרוחני שלה. עובדים שיפרו את המדיניות, הזהירה החברה הקוריאנית, יסתכנו בפיטורים. לפי אתר בלומברג, הפתרון של החברה לבעיה הוא פיתוח כלים פנימיים משלה לתרגום וסיכום של מסמכים וכן לכתיבת קוד.

בשבוע שעבר הצטרפה גם גוגל לאפל ולסמסונג, כאשר ביקשה מעובדיה לא לחשוף מידע רגיש בפני צ'אטבוטים – גם לא בפני בארד שהיא עצמה פיתחה. במקביל הורתה החברה למהנדסי התוכנה שלה לא להשתמש בשורות קוד שנכתבו על ידי צ'אטבוטים. לפי דיווחים מהחודשים האחרונים, גם אמזון, בנק אוף אמריקה, דויטשה בנק, ג'יי־פי מורגן, ורייזון וחברות נוספות אסרו על השימוש בכלים של בינה מלאכותית יוצרת (גנרטיבית) או הגבילו אותו.

רון רייטרצילום: סנטרה

רון רייטרצילום: סנטרה"אנחנו רואים שמידע רגיש של ארגונים דולף למודלים של בינה מלאכותית", מספר רון רייטר, מייסד-שותף וסמנכ"ל הטכנולוגיה בחברת הסייבר סנטרה (Sentra) ל-ynet. "ברגע שהמודלים לומדים את המידע הרגיש הזה, אי אפשר ללכת אחורה. מאוד-מאוד קשה למחוק את המידע הזה או בכלל לדעת שהוא דלף. היו כמה חברות שגילו שמידע שלהן דלף באמצעות שיחה עם המודל".

סנטרה, שהוקמה ב-2021, מפתחת בכלל מוצר להגנה על תשתיות ענן, אבל לדברי רייטר, "אחרי ש-ChatGPT הושק, מנהלי אבטחת מידע בארגונים אמרו לנו שמידע שזולג לצ'אטבוט הפך לבעיה מספר אחת שלהם. זה גרם לנו להבין שאנחנו צריכים רגע לעצור ולהוסיף מעל המוצר הקיים שלנו מוצר נוסף שפותר נקודתית את הבעיה הזאת".

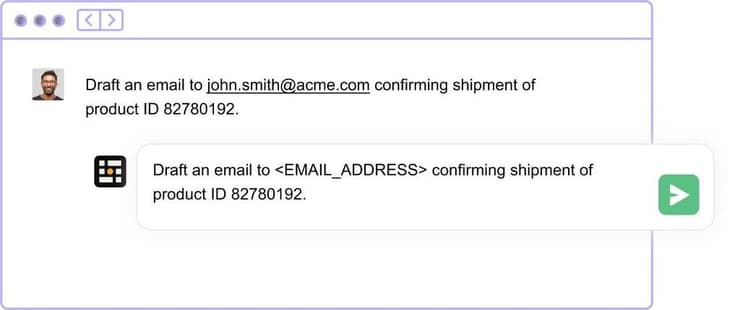

מוקדם יותר החודש חשפה סנטרה תוסף לדפדפן שמיועד לארגונים ומצנזר מידע רגיש כמו שמות, כתובות, כתובות מייל ומספרי אשראי לפני שהוא נשלח לצ'אטבוטים. "בגרסאות הבאות של התוסף, אנחנו נוכל לזהות שמדובר במסמך סודי לפי התוכן שלו", אומר רייטר, "מנהל אבטחת מידע יוכל להגיד לנו למשל שהוא לא רוצה שחוזים ייצאו החוצה – ואנחנו נחסום אותם".

להשתמש דרך ענן

גם חברת קלאודפלייר (Cloudflare) פיתחה כלי שמאפשר לארגונים לתייג מידע ולמנוע ממנו לזלוג החוצה למודלים של בינה מלאכותית. "אם הייתם נותנים לכיתה של סטודנטים באוניברסיטה לנבור במידע הפנימי שלכם, ברור שהייתם מנסחים חוקים ברורים לגבי סוג המידע שאליו הם יכולים לגשת ואיך הם יכולים להשתמש בו לטובת ההשכלה שלהם", אמר מנכ"ל החברה, מתיו פרינס. "הבינה המלאכותית טומנת בחובה הבטחה, אבל בלי אמצעי בטיחות הולמים היא יכולה ליצור סיכונים משמעותיים לעסקים".

ישנם פתרונות נוספים: חלק מחברות הטכנולוגיה מתמודד עם הבעיה באמצעות פיתוח כלים פנימיים שישמשו את העובדים כתחליף ל-ChatGPT או GitHub CoPilot, כמו שפורסם שסמסונג מתכוונת לעשות, אבל זה מן הסתם לא פתרון שמתאים לכל ארגון. אפשרות אחרת היא לגשת למודלים של AI באמצעות חברות הענן, שמבטיחות כי המידע של הלקוחות לא ישמש לאימון. מיקרוסופט, למשל, מציעה גישה למודלים של OpenAI באמצעות שירות הענן שלה Azure, ו-AWS של אמזון מאפשרת בחירה בין המודלים של AI21 הישראלית, אנתרופיק ו-Stabillity AI.

עם זאת, רייטר מזכיר כי "בסוף אי אפשר להבטיח שהעובדים לא ישתמשו בגרסאות החינמיות או הפרטיות של הצ'אטבוטים. זאת הבעיה". מצד שני, גם כלים כמו אלה שהשיקו סנטרה וקלאודפלייר לא מספקים פתרון הרמטי: עובדים יכולים להזין מידע רגיש לצ'אטבוטים גם כאשר הם משתמשים במכשירים הפרטיים שלהם או בסמארטפון.

יכול להיות שפתרונות טכנולוגיים לא מספיקים וצריך גם לחנך את העובדים ולהעלות את המודעות שלהם לנושא?

רייטר: "צריך גם וגם – גם לחנך את העובדים וגם למנוע את הזליגה של המידע החוצה. אחד הפיצ'רים שאנחנו רוצים להוסיף זה ניטור של עובדים שמכניסים מידע רגיש לצ'אטבוטים, מה שיאפשר למנהלים להעיר להם ולבקש מהם לא לעשות את זה שוב".